En el marco de su evento Meta Connect 2024, la tecnológica ha dado a conocer sus últimas novedades, incluido su nuevo modelo de lenguaje, que llega dos meses después de la presentación de Llama 3.1, y que introduce la capacidad de procesar imágenes por primera vez en la compañía.

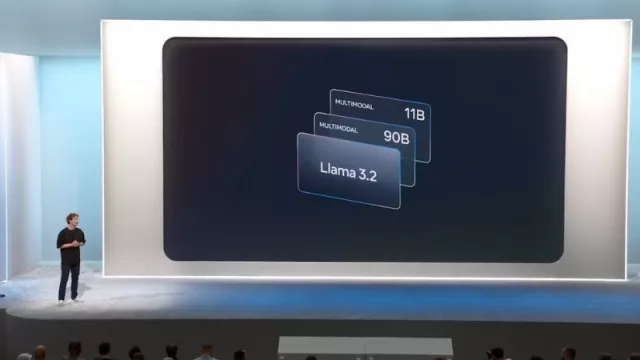

Así, el nuevo modelo Llama 3.2 se compone de dos modelos multimodales pequeño y mediano, con 11.000 millones de parámetros (11B) y 90.000 millones de parámetros (90B) respectivamente. En este sentido, los casos de uso de estos nuevos modelos admiten razonamiento de imágenes, como puede ser la comprensión de gráficos y diagramas o subtítulos de imágenes. Asimismo, también procesan la localización direccional de objetos en imágenes.

Es decir, este modelo permite llevar a cabo acciones como extraer detalles de una fotografía, comprender la escena y, tras ello, crear oraciones que podrían utilizarse como título de la imagen o inicio para contar una historia.

Igualmente, Llama 3.2 se completa con dos modelos de menor tamaño, 1B y 3B, que procesan texto exclusivamente y están ideados para funcionar en dispositivos, como un smartphone. Estos modelos están optimizados para procesadores ARM y pueden resolver múltiples tareas con una latencia mínima, asimismo, admiten una longitud de contexto de 128.000 tokens.

En concreto, estos modelos permiten a los desarrolladores crear aplicaciones personalizadas en el dispositivo, asegurando los datos se mantienen privados dentro del 'smartphone' o producto en cuestión. Por ejemplo, Meta ha señalado que pueden utilizarse para llevar a cabo resúmenes de los diez últimos mensajes recibidos en una 'app' de mensajería instantánea. Igualmente, pueden aplicarse para enviar de forma automática invitaciones de calendario para organizar reuniones.

Sin embargo, la tecnológica ha señalado que estos modelos destacan, sobre todo, por su capacidad de ejecutarse localmente. Por un lado, esta función permite que las indicaciones o respuestas del modelos sean instantáneas, ya que se procesan localmente. Por otra parte, garantiza una privacidad total, al no enviar datos como mensajes o información del calendario a la nube.

COMPETITIVOS CON CLAUDE 3 HAIKU GPT4O-MINI

Según la evaluación de estos modelos ofrecida por Meta, los modelos 3.2 11B y 90B son competitivos con los modelos básicos líderes, Claude 3 Haiku y GPT4o-mini en el reconocimiento de imágenes y una variedad de tareas de comprensión visual.

Por su parte, el modelo 3B supera a los modelos Gemma 2 2.6B y Phi 3.5-mini a la hora de ejecutar tareas como seguir instrucciones, resumir, reescribir indicaciones y usar herramientas. Igualmente, el modelo 1B es en este ámbito con Gemma.

Para llegar a estas conclusiones, Meta evaluó el rendimiento de los modelos en más de 150 conjuntos de datos de referencia que, abarcando una amplia variedad de idiomas.

Con todo ello, la compañía ha señalado que el modelo de lenguaje grande Llama 3.2 de código abierto ya está disponible para todos los desarrolladores, de cara a que empiecen a probar y experimentar sus posibilidades. Asimismo, todas estas capacidades se han incluido en su asistente de IA, Meta AI.

Tu opinión enriquece este artículo: